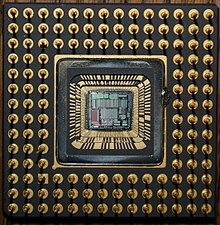

O que vem a ser a Unidade Central de Processamento?

Uma Unidade Central de Processamento ou CPU (Unidade Central de Processamento), também conhecida como processador, é a parte de um sistema de computador que executa as instruções de um programa de computador para realizar aritmética básica, lógica e dados de entrada e saída.

O papel da CPU pode ser comparado ao papel do cérebro no funcionamento de um computador. Ou seja, ele realiza operações lógicas, cálculos e processamento de dados. O termo foi cunhado no início da década de 1960, e seu uso continua até hoje porque sua função básica permanece a mesma, apesar das mudanças dramáticas em sua forma, design e implementação.

O seu conceito

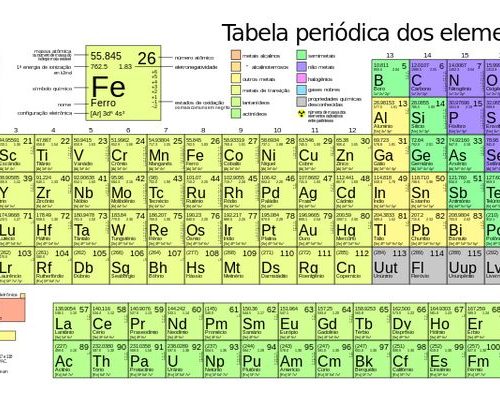

A primeira CPU personalizada foi projetada como parte de um computador mainframe. No entanto, esse método caro de fabricar CPUs personalizadas para aplicativos específicos levou ao desenvolvimento de processadores produzidos em massa para uma ou mais finalidades. Essa tendência geral de padronização começou nos dias de minicomputadores discretos e transistores de mainframe e acelerou rapidamente com a proliferação de circuitos integrados (ICs).

Os CIs permitem que processadores cada vez mais complexos sejam projetados e fabricados em nanoescala. Tanto a miniaturização quanto a padronização dos processadores aumentaram a presença desses dispositivos digitais na vida moderna, muito além das limitadas aplicações dedicadas aos computadores. Microprocessadores modernos são encontrados em tudo, desde carros a telefones celulares e brinquedos infantis.

Em máquinas maiores, a CPU pode exigir uma ou mais placas de circuito impresso. Em computadores pessoais e pequenas estações de trabalho, a CPU reside em um único chip de silício chamado microprocessador. Desde a década de 1970, CPUs do tipo microprocessador superaram quase completamente todas as outras implementações de CPU. CPUs modernas são circuitos integrados de grande escala em pequenos pacotes retangulares com vários pinos de conexão.

A maioria dos autores consiste basicamente nos três componentes a seguir:

Unidade Lógica e Aritmética (ULA ou ALU): realiza operações lógicas e aritméticas;

Unidade de Controle (UC): decodifica instruções, busca operandos, controla pontos de execução e desvios;

Registradores: Armazenar dados para processamento.

OBS.: Alguns autores também incluem caches (L1, L2 e L3) na mesma classe de registradores como componente da CPU.

Sua história

EDVAC, um dos primeiros computadores.

Computadores como o ENIAC tinham que ser fisicamente reconectados para executar tarefas diferentes, então essas máquinas eram frequentemente chamadas de “computadores de programa fixo”. Como o termo “CPU” é frequentemente definido como um dispositivo usado para executar software (programas de computador), os primeiros dispositivos que poderiam ser chamados de CPUs surgiram com o advento dos computadores com programas armazenados.

A ideia de um programa de computador havia sido proposta no projeto ENIAC de J. Presper Eckert e John William Mauchly, mas foi inicialmente omitida para que a máquina pudesse ser concluída em um tempo muito menor. Em 30 de junho de 1945, antes da conclusão do ENIAC, o matemático Johann von Neumann distribuiu um documento intitulado “Esboço Preliminar do Relatório EDVAC”. Descreve o projeto de um programa de computador armazenado a ser concluído em agosto de 1949. [4] EDVAC é projetado para executar muitos tipos diferentes de instruções (ou operações). Essas instruções podem ser combinadas para criar programas úteis para a execução do EDVAC.

Vale a pena notar que os programas escritos para o EDVAC são armazenados na memória do computador de alta velocidade, não especificada pelas conexões físicas do computador. Isso supera uma séria limitação do ENIAC, o tempo e o esforço necessários para reconfigurar um computador para executar uma nova tarefa. De acordo com o projeto de von Neumann, os programas ou software em execução no EDVAC poderiam ser alterados alterando o conteúdo da memória do computador.

Enquanto von Neumann é mais frequentemente considerado o desenvolvedor de computadores de programa armazenado, por causa de sua visão para EDVAC, outros antes dele, como Konrad Zuse, propuseram e implementaram ideias semelhantes. A chamada arquitetura Harvard do Harvard Mark I, concluída antes do EDVAC, também empregava um projeto de programa armazenado que usava fita de papel perfurada em vez de memória eletrônica. A diferença fundamental entre as arquiteturas de Von Neumann e Harvard é que a última separa o armazenamento e o processamento de instruções e dados da CPU, enquanto a primeira usa o mesmo espaço de memória para ambos. A maioria dos processadores modernos são principalmente von Neumann em design, mas elementos da arquitetura de Harvard também são comuns.

Como um dispositivo digital, uma CPU é limitada a um conjunto de estados discretos e requer algum tipo de elemento de comutação para diferenciar e alterar os estados. Antes do desenvolvimento comercial de transistores, relés e tubos de vácuo eram comumente usados como elementos de comutação.

Embora esses projetos oferecessem vantagens consideráveis de velocidade em relação aos projetos puramente mecânicos anteriores, eles não eram confiáveis por várias razões. Por exemplo, construir circuitos lógicos sequenciais CC fora dos relés requer hardware adicional para lidar com problemas de contato. Embora as válvulas não experimentem repulsão de contato, elas devem aquecer antes da operação completa e, eventualmente, falhar devido à lenta contaminação catódica que ocorre durante a operação normal. A contaminação catódica é acelerada se a válvula selada vazar (o que às vezes acontece).

Muitas vezes, quando um tubo falha, a CPU deve ser inspecionada para encontrar o componente com falha para que possa ser substituído. Assim, os primeiros computadores eletrônicos (baseados em tubos) eram geralmente mais rápidos, mas menos confiáveis do que os computadores eletromecânicos (baseados em relés).

Computadores baseados em vácuo como o EDVAC tendem a trabalhar em média 8 horas antes de falhar, enquanto computadores baseados em relé como o (mais lento, porém anterior) Harvard Mark I raramente falham. [3] No final, as CPUs baseadas em Valve dominaram porque suas vantagens significativas de velocidade geralmente superavam os problemas de confiabilidade. A maioria dessas CPUs mais antigas funciona com frequências de clock mais baixas em comparação com os designs microeletrônicos modernos. Sinais de freqüência de clock na faixa de 100 kHz a 4 MHz são muito comuns neste momento, amplamente limitados pela velocidade dos dispositivos de comutação que estão sendo construídos.

CPUs baseadas em transistores discretos e circuitos integrados

A CPU, memória de núcleo e barramento externo do DEC PDP-8/I. Feito de circuitos integrados de média escala.

Como várias tecnologias tornaram mais fácil construir dispositivos eletrônicos menores e mais confiáveis, a complexidade do design da CPU aumentou. A primeira melhoria veio com o advento dos transistores. As CPUs de transistor das décadas de 1950 e 1960 não precisavam mais ser construídas com elementos de comutação volumosos, não confiáveis e frágeis, como válvulas e relés. Com essa melhoria, CPUs mais complexas e confiáveis são construídas em uma ou mais placas de circuito impresso com componentes discretos (single).

Durante esse tempo, um método de fabricação de transistores em um espaço compacto tornou-se popular. Os circuitos integrados (ICs) permitem a fabricação de um grande número de transistores em uma única matriz ou “chip” baseada em semicondutores. No início, apenas circuitos digitais não especializados e muito básicos, como portas NOR, foram miniaturizados em CIs. As CPUs baseadas nesses ICs de “bloco de construção” são frequentemente chamadas de dispositivos “Small Scale Integration” (SSI). CIs SSI, como aqueles usados em computadores orientados para Apollo, normalmente contêm dez vezes a soma de transistores.

Construir uma CPU inteira com CIs SSI requer milhares de chips individuais, mas consome muito menos espaço e energia do que os modelos anteriores baseados em transistores discretos. À medida que a microeletrônica avançava, mais e mais transistores eram colocados em CIs, reduzindo o número de CIs individuais necessários para uma CPU completa. Os circuitos integrados MSI e LSI (Integração de Média e Grande Escala) aumentam a soma dos transistores em centenas, depois milhares.

O microprocessador

A introdução do microprocessador na década de 1970 influenciou muito o projeto e a implementação dos processadores.

Com a introdução do primeiro microprocessador comercial (Intel 4004) em 1970, e mais tarde o primeiro microprocessador de 16 bits (Intel 8080) em 1974, os microprocessadores dominaram rapidamente o mercado e se estabeleceram como o tipo de CPU mais utilizado. quase sinônimo.

Os microprocessadores usam circuitos integrados de transistores, percebendo assim as vantagens dos processadores de transistores, economizando espaço, energia e gerando menos calor. Por esses motivos, eles também podem atingir frequências de clock mais altas, o que significa mais operações por segundo e, portanto, velocidades mais rápidas percebidas pelo usuário.

O tamanho menor também permite a inclusão de memória cache, que permite que os circuitos atinjam velocidades mais altas ao executar programas sem precisar recorrer a frequências de clock mais altas. Como clocks mais altos significam mais consumo de energia e mais calor para dissipar, o aumento de desempenho que vem com a inclusão dessas memórias é crucial para o advento dos smartphones.